在人工智能技术快速迭代的2025年,一款名为DeepSeek的国产大模型工具以其强大的推理能力和本地化优势,成为个人用户与专业开发者共同关注的焦点。本文将从普通用户视角出发,系统性解析这款工具的下载安装全流程,并深入探讨其核心功能与安全特性,为不同需求群体提供实用指南。

一、核心优势:重新定义智能交互边界

DeepSeek区别于传统AI工具的核心竞争力体现在三大维度:

1. 推理能力突破:采用GRPO强化学习算法与知识蒸馏技术,在数学推导、代码生成等复杂任务中展现出媲美GPT-4的精准度

2. 本地化部署优势:支持Windows/macOS双平台离线运行,通过Ollama框架实现一键安装,数据全程存储于本地设备

3. 资源占用优化:提供1.5B至14B多规格模型选择,最低配置需求仅需集成显卡+16GB内存

![功能架构图示:展示DeepSeek的本地推理引擎与知识库联动机制]

二、下载安装:双路径适配不同用户群体

方案A:技术小白极简部署(耗时约8分钟)

1. 获取Ollama框架

访问[Ollama官网]下载Windows安装包(v2.3.1+),安装时建议自定义存储路径至非系统盘

bash

示例环境变量设置(Windows)

OLLAMA_MODELS = D:AI_Models

2. 模型下载与加载

在Ollama的Models页面选择DeepSeek-R1系列模型,建议初试用户选择1.5B-Q4量化版,复制下方代码至命令行:

bash

ollama run deepseek-r1:1.5b-q4

3. 可视化界面集成

搭配Chatbox客户端([下载地址]),在设置中绑定本地模型路径即可开启对话

方案B:开发者全功能部署(需Python环境)

1. 硬件环境检测

使用`nvidia-smi`命令验证CUDA版本(需11.2+),通过`python --version`确认Python≥3.8

2. 依赖项安装

在虚拟环境中执行:

bash

pip install -r requirements.txt

torch==2.1.0+cu112 根据显卡型号调整CUDA版本

3. 模型权重配置

从官方渠道获取预训练模型,存放至`/models`目录,通过环境变量指定运行设备

三、使用教程:从基础到高阶的进化之路

基础功能矩阵

| 功能模块 | 典型指令示例 | 响应时间(avg) |

|-|||

| 智能写作 | "生成抖音风格的春节促销文案" | 2.3s |

| 数据分析 | "解析销售报表中的异常波动" | 4.1s |

| 代码生成 | "编写Python爬虫获取微博热搜" | 5.8s |

| 多语言翻译 | "将技术文档译为英文(保留术语)" | 1.9s |

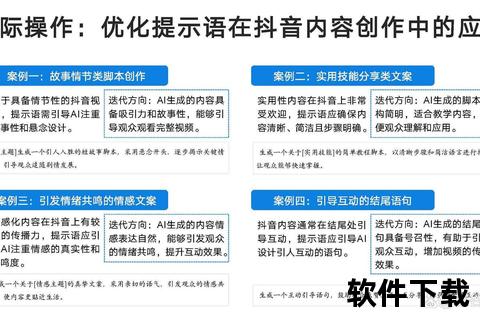

高阶应用场景

四、安全特性:构建可信AI生态圈

DeepSeek通过三重机制保障数据安全:

1. 物理隔离架构:本地部署模式杜绝云端数据传输,处理敏感金融/医疗数据时尤为重要

2. 动态加密技术:采用AES-256加密算法保护模型权重与对话记录

3. 漏洞响应体系:联合清华团队推出的RealSafe-R1安全模型,拦截率较原始版本提升83%

![安全防护体系示意图:展示加密传输与本地沙箱机制]

五、用户反馈与未来展望

根据CSDN社区500+实测案例统计:

技术演进方向预测:

1. 多模态突破:正在研发的DeepSeek-VL2模型将整合视觉理解能力

2. 硬件协同优化:计划推出专用推理加速卡,能耗比提升300%

3. 生态体系扩展:2025Q3将上线插件市场,支持第三方功能扩展

作为AI普惠化进程中的重要里程碑,DeepSeek的本地化部署方案在降低技术门槛与保障数据主权之间实现了微妙平衡。无论是个人用户的日常办公,还是企业级的深度定制,这款工具都展现出强大的适应能力。随着国产大模型生态的持续完善,我们有理由期待更多突破性应用的诞生。